[프라이버시 리스크]데이터 먹고 자란 AI, 규제 논의 본격화AI-프라이버시 불가분 관계, 리스크 관리 필수

이종현 기자공개 2025-01-13 08:20:20

[편집자주]

개인정보 보호가 기업의 새로운 리스크로 떠올랐다. 세계 각국은 자국민의 개인정보를 지키기 위한 법 체계를 강화하는 경쟁을 벌이고 있다. 법 위반에 따른 제재도 강화되면서 수조원대 과징금을 부과받은 사례도 나타났다. 데이터를 핵심 자원으로 삼는 AI 시대의 도래로 '프라이버시 리스크'는 더 커질 것으로 예상된다. 개인정보 보호를 둘러싼 국내외 동향과 이에 대응하는 기업·기관의 움직임을 살펴본다.

이 기사는 2024년 12월 27일 16:10 thebell 에 표출된 기사입니다.

인공지능(AI)의 등장 이후 개인정보의 중요도는 더 커졌다. AI 학습을 위해 데이터를 수집·활용하는 과정에서 개인정보 역시 포함돼 있기 때문이다. 치열해지는 AI 경쟁이 개인의 프라이버시를 침해할 수 있다는 우려가 곳곳에서 터져 나오고 있다.문제는 기존 개인정보보호법이 AI 기술에 적용할 수 없는 경우가 점차 늘고 있다는 점이다. 산·학계 전문가들을 중심으로 개인에게 책임을 미루는 대신 선제적인 조치가 필요하다는 요구가 빗발치면서 AI 환경에서의 프라이버시 보호를 위한 제도가 논의되기 시작했다. 국내에서도 국가 개인정보 전문기관은 개인정보보호위원회(이하 개인정보위)를 중심으로 관련 조치가 이뤄지는 중이다.

◇AI 프라이버시 리스크 관리모델

개인정보위는 12월 19일 '안전한 AI·데이터 활용을 위한 AI 프라이버시 리스크 관리 모델'(이하 안내서)을 발표했다. 기업·기관이 AI 기술을 도입·적용할 때 프라이버시 리스크 관리의 방향과 원칙을 제시하는 것이 골자다.

안내서 논의를 이끈 박상철 서울대 교수는 "빠르게 발전하는 AI 기술과 기존 개인정보보호 규제 간 간극과 긴장이 발생하고 있어 대응이 필요한 시점"이라며 안내서 마련 배경을 설명했다.

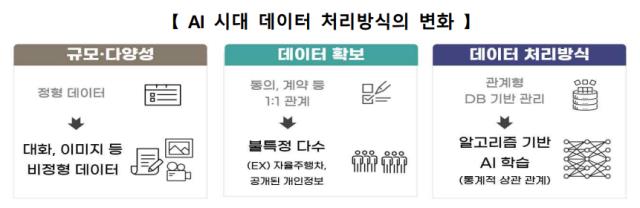

안내서에서는 AI와 프라이버시에 대해 "AI 발전은 개인정보를 포함한 대규모 데이터 처리에 기초하고 있어 AI와 프라이버시 리스크는 불가분 관계"라며 "AI 기술이 요구하는 데이터 처리방식의 근본적인 변화는 개인정보 유·노출 등 전형적인 프라이버시 리스크를 심화시키고 기존 환경에서 예측하지 못한 새로운 리스크를 유발한다"고 설명했다.

불확실성이 높은 AI 영역에서 리스크 기반 접근을 통해 부작용을 관리하며 AI 기술의 이점을 극대화하는 데 주안점을 둔다. 적용 대상과 리스크 범위, 기타 법령 또는 안내서와의 관계 등을 포함해 구체적인 관리 절차, 식별·경감 방안 등이 포함됐다.

구체적인 리스크 유형으로는 적접하지 않은 학습데이터 수집·이용과 학습데이터의 부적절한 보관·관리, AI 가치망 데이터흐름의 복잡화 등을 제시했다. 대규모 개인정보 수집·이용이 늘면서 기업의 법준수 리스크가 커진 만큼 그에 따른 적법성을 확보하는 것이 중요하다는 것이 개인정보위의 지적이다.

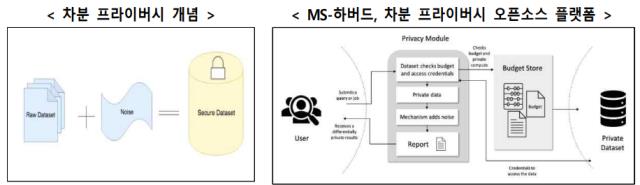

관리적 조치에 대한 안내뿐만 아니라 기술적 조치에 대한 내용도 포함된 점이 눈길을 끈다. 학습데이터 전처리 과정에서 정보를 가명·익명화해 처리하거나 중복제거 기술을 적용하도록 하는 등의 내용이다.

또 기술적으로 생성한 가상 합성데이터의 활용이나 사람 피드백 기반 강화학습(RLHF) 등 미세조정 방법론이나 사생활 침해 우려가 큰 답변 생성을 유도할 경우 답변 생성을 거절하는 등의 입·출력 필터링 기술도 소개했다. 국내 LLM 4개 모델을 선정해 경감 기술을 적용하는 실험한 후 관련 연구 결과를 담기도 했다.

◇빈번하게 발생 중인 AI 프라이버시 리스크

실제 AI 학습을 위해 적법 근거 없이 무분별하게 개인정보를 수집·이용하는 사례는 빈번하게 발생하고 있다. AI가 암기한 개인정보를 원본 그대로 노출하면서 이름·집주소 등이 노출되거나, 개인의 신원을 도용해 가짜 정보를 생성하는 등의 일이 빚어지기도 한다. 2021년 발생한 '이루다 사태'가 이 케이스다.

이루다 사태는 AI 기술이 프라이버시 리스크로 이어진다는 점을 보여준 대표 사례로 꼽힌다. 스타트업이 특정 서비스를 통해 수집한 개인정보를 새로운 AI 채팅 서비스의 개발에 활용했고, 채팅 과정에서 AI가 계좌번호나 주소 등 민감한 정보를 답변하는 일이 벌어져 논란이 된 건이다. 해당 스타트업은 법 위반으로 과징금·과태료로 약 1억원의 징계를 받았다.

1억원이라는 과징금·과태료가 피해에 비해 너무 가볍다는 비판이 제기되기도 했다. 다만 개인정보보호법 위반에 대한 과징금·과태료 규모는 기업의 매출 규모에 따라 결정된다. 2020년 기준 스캐터랩의 매출액은 약 10억원이다. 연간 매출액의 10%에 달하는 제재가 내려진 셈이다.

이루다 이후 눈에 띄는 AI 프라이버시 관련 제재 사례는 등장하지 않았다. 다만 학습 데이터를 공개하지 않아 제재로까지 이어지지 않을 뿐, 대다수 기업들이 관련 리스크에서 자유롭지 못하다는 것이 업계 중론이다. AI로 인해 불거지는 저작권 논쟁도 같은 맥락이다.

'챗GPT' 등장 이후 AI에 대한 관심이 커졌고 본격적인 도입·적용이 예상되면서 AI 프라이버시 리스크에 대한 우려도 확산되고 있다. 이루다에 대한 처분이 내려진 2021년 대비 처벌조항도 강화됐다. 만일 대기업에서 비슷한 사고가 발생할 경우 수백억원 이상의 과징금·과태료를 각오해야 하는 만큼 각별한 주의가 필요하다.

< 저작권자 ⓒ 자본시장 미디어 'thebell', 무단 전재, 재배포 및 AI학습 이용 금지 >

관련기사

best clicks

최신뉴스 in 전체기사

-

- [인사이드 헤지펀드]"LG CNS IPO 노린다"…라이프운용 하이일드펀드 설정

- [코리아 디스카운트 해소법안 점검]'세법-상법' 개정안 희비교차…행동주의펀드 촉각

- 미래에셋운용, NPL본부 힘 싣는다…조직 확대 개편

- '코레이트운용-공무원공단' 소송전, 10년만에 뒤집혔다

- [Policy Radar]퇴직연금 기금형 도입 검토…업계 '혼란'

- [인사이드 헤지펀드]유니스토리운용, 자산배분 전략 강화…KB 출신 임원 합류

- WM 영토 넓히는 미래에셋…삼성증권은 '선택과 집중'

- 미래에셋 WM, 'NH 프리미어블루' 안방에 둥지 튼다

- 까다로운 타임폴리오, '1조 밸류' 리브스메드 꽂혔다

- [thebell note]'탈'한국 리츠 ETF의 생존 방정식

이종현 기자의 다른 기사 보기

-

- [프라이버시 리스크]데이터 먹고 자란 AI, 규제 논의 본격화

- [프라이버시 리스크]'제재 단골' 카카오, 역대 최대 과징금 여파는

- [i-point]한컴라이프케어, 북미 방독면 독점 공급 계약 체결

- [포스트 망분리 시대 개막]휴네시온, 망분리 축소 여파 불확실성 '점증'

- [포스트 망분리 시대 개막]'망연계' 한싹, 클라우드·제로 트러스트 집중

- [Company Watch]본느 증선위 제재, 에스에스알 전철 밟을까

- [IR Briefing]와이즈넛 "AI 업계 유일 흑자 기업, 성장 자신"

- [i-point]휴마시스, 코로나19·HIV 진단 제품 성능 개선

- [i-point]크라우드웍스, 'AI 트렌드 리포트 2025' 발간

- [i-point]에스넷그룹, CES 2025 참관단 파견